Dans ce qui pourrait être un autre exemple de biais de l’IA pour les manuels scolaires futurs, le fabricant d’autocollants WhatsApp aurait généré des images violentes lorsqu’on lui a demandé de Muslim Palestinians – et s’est abstenu de le faire pour les Israéliens juifs. L’application de messagerie propriété de Meta permet aux utilisateurs d’utiliser l’IA pour générer des autocollants: des images et des animations qui peuvent être incluses dans des conversations. Pourquoi? Parce que c’est amusant. À la suite d’une demande contenant les mots « Palestinien », « Palestine » ou « garçon musulman palestinien », le logiciel de génération, nous dit-on, a proposé des autocollants de personnages garçonniers portant des vêtements islamiques et tenant ce qui ressemblait à un fusil AK-47. Mais lorsque les utilisateurs lui ont demandé de générer des autocollants de « garçon israélien » ou de « garçon juif israélien », il a fourni des visuels bénin de personnages virtuels souriant et dansant, a rapporté The Guardian. Certains d’entre eux semblaient montrer des enfants juifs jouant au football ou brandissant le drapeau israélien au lieu de fusils. Même lorsqu’on leur a demandé de produire des images de « l’armée israélienne » ou des « forces de défense israéliennes », les soldats représentés par l’IA ne brandissaient pas de fusils. Dans un autocollant, un homme avec deux épées dans le dos semblait prier. Toutes les demandes contenant les mots « Hamas » ont été bloquées, cependant, et l’application a indiqué qu’elle ne pouvait « pas générer d’autocollants IA. Veuillez réessayer. »

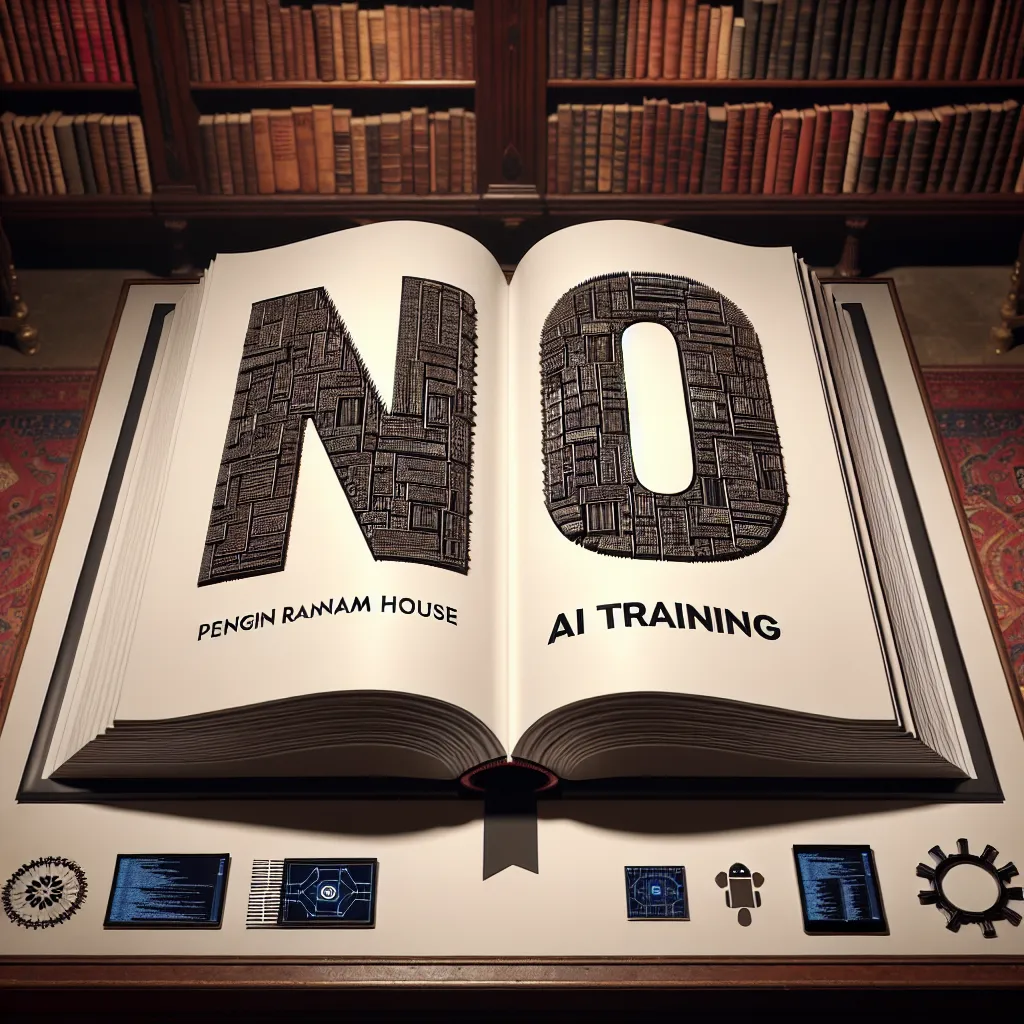

« Les livres de Penguin Random House disent maintenant explicitement ‘non’ à la formation IA »

‘Écrit par Emma Roth, dont le portfolio couvre aussi bien les percées technologiques grand public, les dynamiques de l’industrie du