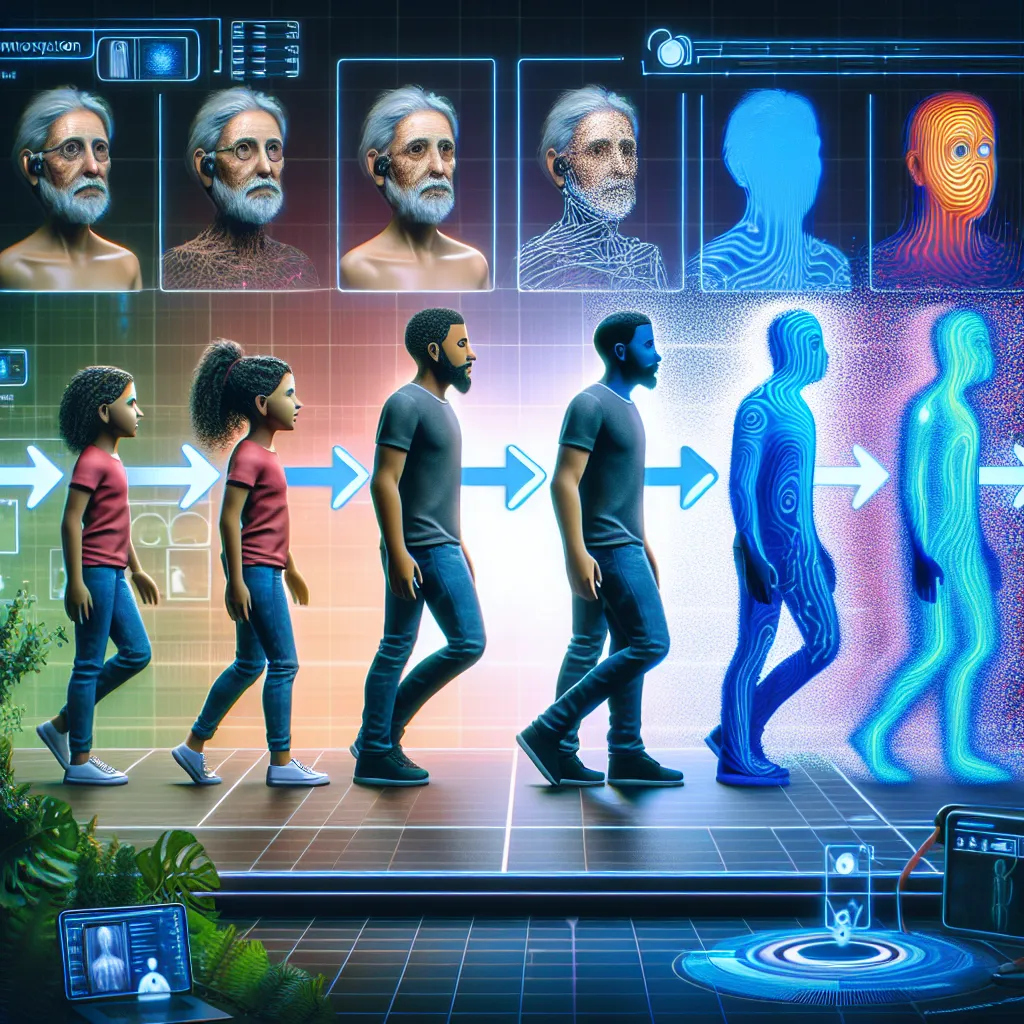

Les Roombas peuvent être à la fois pratiques et amusantes, surtout pour les chats qui aiment monter sur le dessus des machines pendant qu’elles font le ménage. Mais les caméras d’évitement d’obstacles collectent des images de l’environnement, parfois des images assez personnelles, comme cela a été le cas en 2020 lorsque des images d’une jeune femme aux toilettes capturées par un Roomba ont fuité sur les réseaux sociaux après avoir été téléchargées sur un serveur cloud. C’est un problème épineux dans cette ère numérique très en ligne, où les caméras connectées à Internet sont utilisées dans diverses applications de surveillance à domicile et de santé, ainsi que dans des applications plus orientées vers le public comme les véhicules autonomes et les caméras de sécurité. Les ingénieurs de l’Université du Michigan (UM) ont mis au point une possible solution : PrivacyLens, une nouvelle caméra capable de détecter les personnes dans les images en fonction de la température corporelle et de remplacer leur ressemblance par un personnage en forme de bâton générique. Ils ont déposé un brevet provisoire pour l’appareil, décrit dans un article récent publié lors du Symposium sur les technologies améliorant la vie privée, tenu le mois dernier. « La plupart des consommateurs ne se soucient pas de ce qui arrive aux données collectées par leurs appareils domestiques intelligents préférés. Dans la plupart des cas, le son brut, les images et les vidéos sont diffusés à partir de ces appareils vers les serveurs basés sur le cloud des fabricants, que les données soient nécessaires ou non pour l’application finale », a déclaré le co-auteur Alanson Sample. « Un appareil intelligent qui supprime les informations personnellement identifiables (IPI) avant que des données sensibles soient envoyées vers des serveurs privés sera un produit bien plus sûr que ce que nous avons actuellement. » Les auteurs ont identifié trois types de menaces de sécurité distinctes associées à de tels appareils. L’incident du Roomba est un exemple de surcollecte de données, en dehors de ce que l’utilisateur aurait pu consentir à être collecté, ainsi qu’un accès autorisé avec partage non autorisé. (Des travailleurs indépendants au Venezuela chargés d’étiqueter les données pour former l’IA ont publié les images révélatrices sur des forums en ligne.) Un hacker extérieur constitue un accès non autorisé. Par exemple, les sonnettes intelligentes ont des flux de caméra « cryptés », et les utilisateurs pourraient donc penser que leur vie privée est sécurisée. Cependant, ces flux peuvent néanmoins être accessibles aux employés des fabricants d’appareils, aux courtiers en données, à des tiers ou à des agences d’application de la loi, ainsi qu’aux hackers. Lorsqu’en 2012, des caméras de surveillance à l’entrée d’une station de métro au Massachusetts ont capturé une femme tombant d’un escalator, quelqu’un de l’Autorité des transports de la baie du Massachusetts a inexplicablement partagé la vidéo avec la presse et sur YouTube. Elle a rapidement été retirée, mais pas avant que de nombreuses copies aient été faites. La vidéo révélait des IPI tels que son visage, sa couleur de cheveux et sa couleur de peau.

Informatique à Haguenau

Informatique à Haguenau : Solutions complètes pour tous vos besoins informatiques La ville de Haguenau, idéalement située en Alsace, est