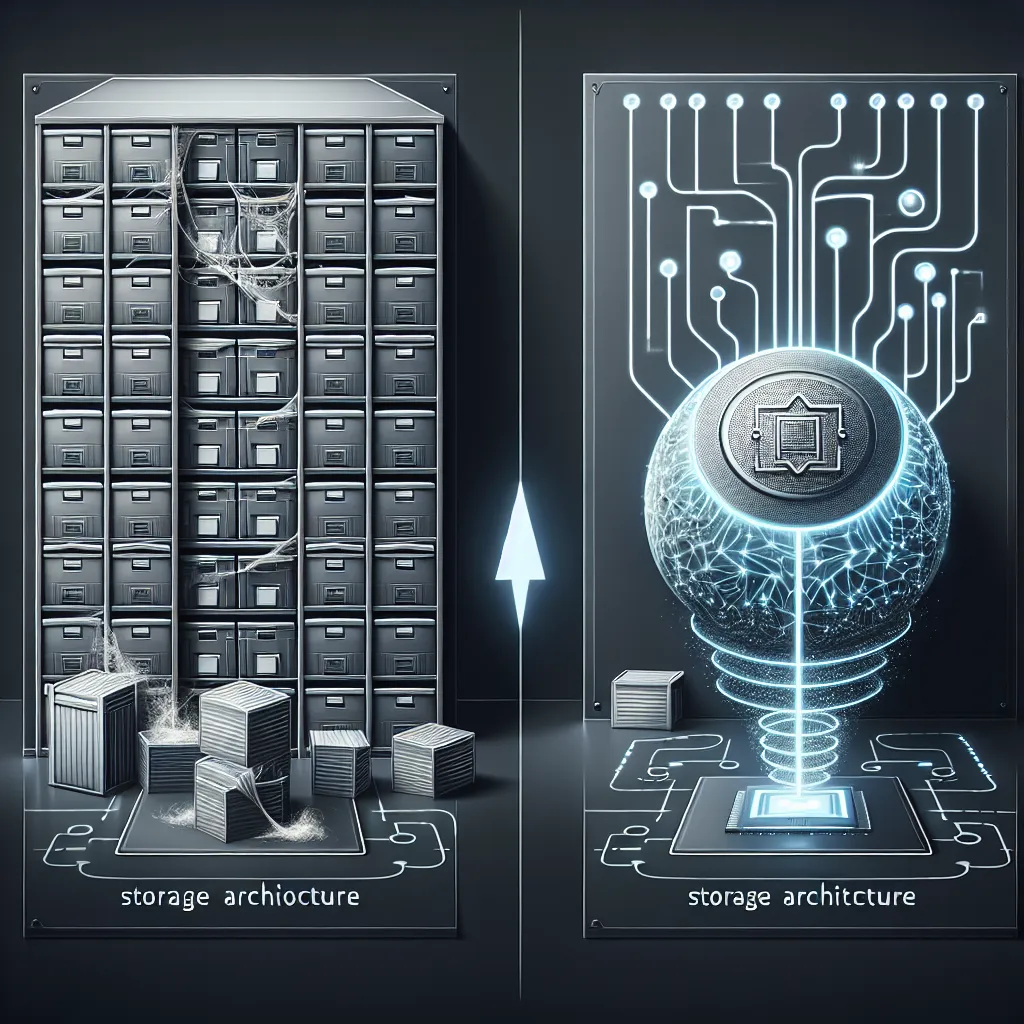

La montée en puissance continue de l’intelligence artificielle a provoqué un changement dans les méthodes de calcul, passant du CPU au GPU, et les architectures de stockage devront s’adapter pour répondre aux nouvelles exigences des charges de travail de l’IA, selon un responsable de Huawei. Comme l’a illustré la montée en puissance sans précédent de Nvidia en tant que fabricant de puces IA par excellence, l’industrie a déplacé une grande partie de ses demandes de calcul vers les centres de données GPU pour former leurs modèles IA. Peter Zhou, président de la ligne de produits de stockage de données chez Huawei, estime qu’il doit y avoir un changement correspondant dans les systèmes de stockage pour répondre aux besoins de ces installations basées sur les GPU. S’adressant à ITPro, Zhou a expliqué comment l’industrie du stockage est restée relativement stagnante au cours de la dernière décennie, mais que les avancées en matière d’apprentissage machine, d’IA générative et de big data continueront de perturber l’espace et de contraindre les fournisseurs à innover. « Il n’y avait vraiment pas de grands changements se produisant dans ce domaine, l’industrie comme EMC ou NetApp, elles ont fait ce qu’elles faisaient depuis dix ans. Leur produit n’a pas vraiment été modifié depuis environ dix ans, mais lorsque le big data et l’IA sont devenus réalité, tout a changé », a-t-il expliqué.

Informatique à Haguenau

Informatique à Haguenau : Solutions complètes pour tous vos besoins informatiques La ville de Haguenau, idéalement située en Alsace, est