Article sponsorisé Lisez cette interview du Register pour découvrir ce que le professeur Onur Mutlu de l’ETH Zürich pense de l’architecture informatique que nous devrions déployer pour répondre aux exigences de la prochaine génération.

Le Register : Si l’on examine le fonctionnement de l’architecture informatique aujourd’hui, quels sont les défis et les lacunes de ce modèle?

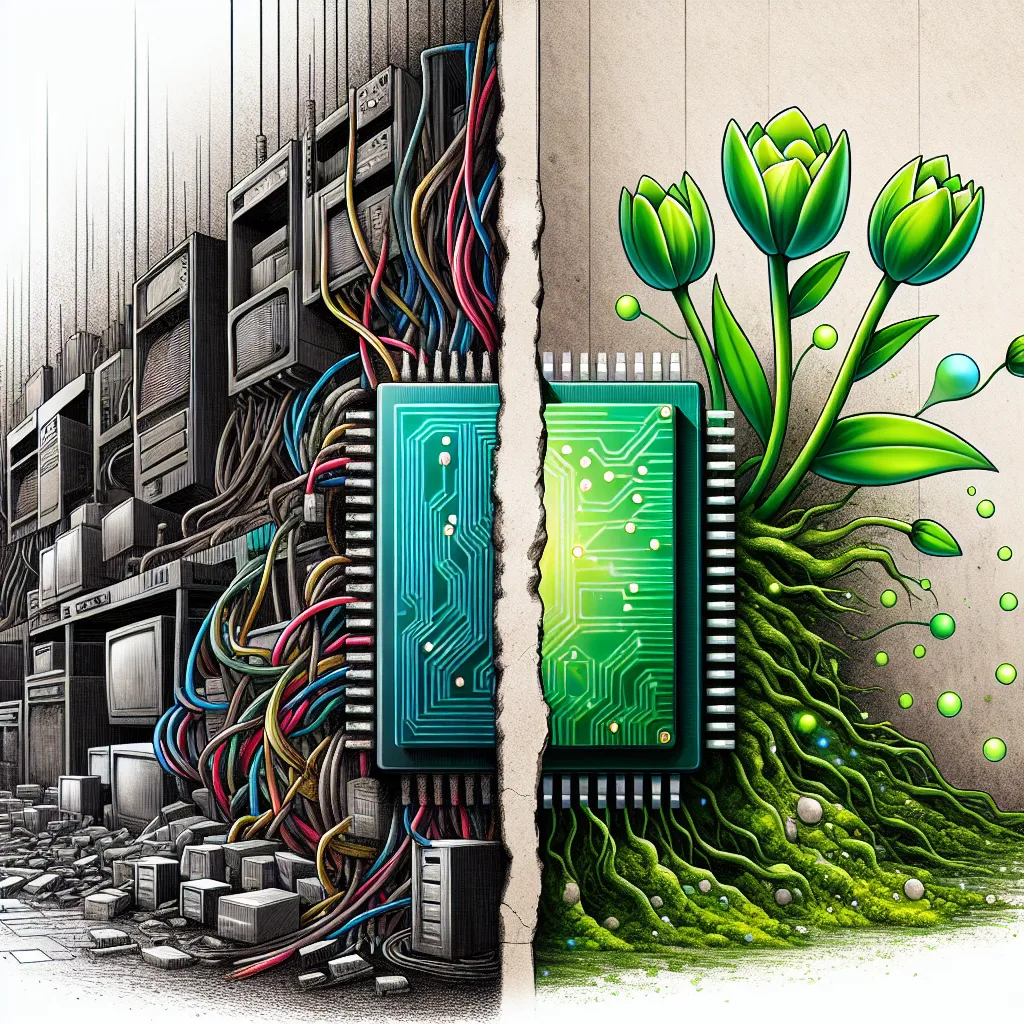

Professeur Onur Mutlu : Il y a des problèmes majeurs avec la façon dont nous concevons les systèmes informatiques aujourd’hui. L’un des plus grands est que bien que les ensembles de données augmentent et que nous essayons de réaliser des tâches plus sophistiquées avec eux, les composants qui effectuent les calculs réels ne représentent qu’une très petite fraction du système. Sur un nœud typique, plus de 98 pour cent de ce nœud sont dédiés au stockage, au contrôle et au déplacement des données, alors que les processeurs qui opèrent sur ces données ne représentent qu’une petite partie de l’ensemble. La façon dont nous concevons nos systèmes est très centrée sur le processeur. Le processeur est roi, et tout doit se déplacer vers lui pour que vous puissiez effectuer des calculs. Le système de stockage, le système de mémoire et les interconnexions ne sont pas des composants actifs travaillant de manière productive sur ces calculs. Lorsque vous déplacez continuellement des données entre le processeur et les sous-systèmes mémoire ou stockage, cela constitue un goulot d’étranglement majeur.

Reg : Comment cela se combine-t-il avec l’ère des applications lourdes en données?

OM : Il est de plus en plus courant que nous devions stocker de nombreux téraoctets de données provenant d’applications telles que l’apprentissage automatique et la génomique. Nous avons réalisé une étude avec Google où nous avons examiné de grands modèles d’apprentissage automatique, ceux qui utilisent des accélérateurs d’apprentissage automatique, et nous avons constaté que plus de 90 pour cent de l’énergie totale du système est en réalité dépensée pour l’accès à la mémoire. Cela pose à la fois des problèmes d’énergie et de performances. La plupart du potentiel de votre matériel est gaspillé, ce qui pose également des problèmes de durabilité. Tout ce matériel de traitement qui n’est utilisé que pour stocker des données se traduit par beaucoup de carbone gaspillé.

Alerte Cybersécurité : Le Malware TamperedChef se Propage via de Faux Installateurs

Une nouvelle campagne de cyberattaque mondiale a été détectée, utilisant un malware sophistiqué nommé TamperedChef (ou BaoLoader) qui se propage