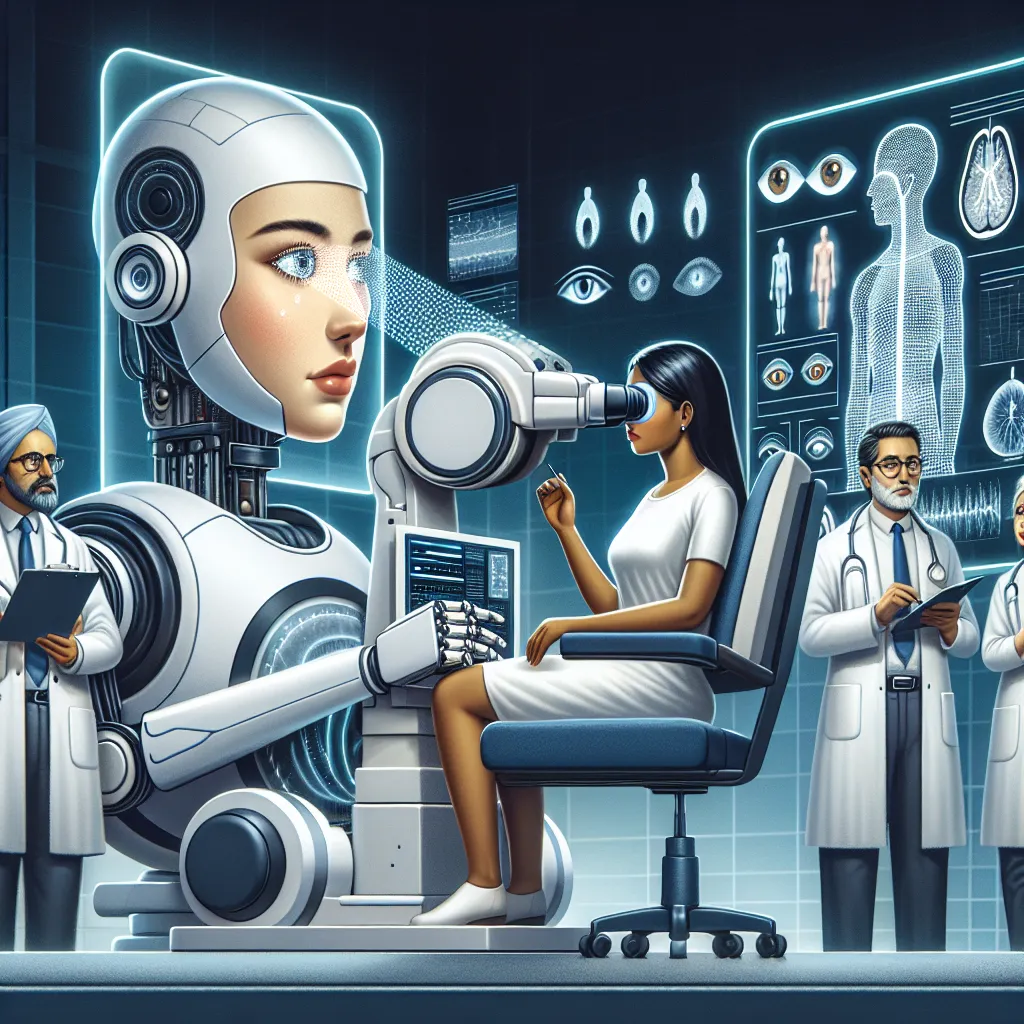

Alors que les modèles d’apprentissage des langues (LLMs) continuent de progresser, des questions émergent sur la façon dont ils peuvent bénéficier à la société, notamment dans des domaines tels que la médecine. Une étude récente de l’École de médecine clinique de l’Université de Cambridge a révélé que le GPT-4 d’OpenAI s’est presque aussi bien comporté qu des experts en ophtalmologie, rapporte en premier lieu le Financial Times. Dans l’étude, publiée dans PLOS Digital Health, les chercheurs ont testé le LLM, son prédécesseur GPT-3.5, le PaLM 2 de Google et le LLaMA de Meta avec 87 questions à choix multiples. Cinq ophtalmologistes experts, trois ophtalmologistes en formation et deux médecins juniors non spécialisés ont passé le même examen fictif. Les questions provenaient d’un manuel destiné aux stagiaires et couvraient tout, de la sensibilité à la lumière aux lésions. Les contenus ne sont pas accessibles au public, donc les chercheurs estiment que les LLMs n’auraient pas pu être entraînés dessus antérieurement. ChatGPT, équipé de GPT-4 ou de GPT-3.5, a eu trois tentatives pour répondre de manière définitive, sinon sa réponse a été considérée comme nulle. Le GPT-4 a obtenu un score supérieur à celui des stagiaires et des médecins juniors, en répondant correctement à 60 des 87 questions. Bien que ce score soit nettement supérieur à la moyenne de 37 bonnes réponses des médecins juniors, il a tout juste dépassé la moyenne de 59,7 des trois stagiaires. Alors qu’un ophtalmologiste expert n’a répondu correctement qu’à 56 questions, ceux-ci ont obtenu en moyenne 66,4 bonnes réponses, battant la machine. Le PaLM 2 a obtenu 49 points et le GPT-3.5 42 points. Le LLaMa a obtenu le score le plus faible avec 28 points, se plaçant en dessous des médecins juniors. Notons que ces essais ont eu lieu à la mi-2023. Bien que ces résultats présentent des avantages potentiels, il existe également plusieurs risques et préoccupations. Les chercheurs ont souligné que l’étude comportait un nombre limité de questions, surtout dans certaines catégories, ce qui signifie que les résultats réels pourraient être variés. Les LLMs ont également tendance à « halluciner » ou à inventer des choses. Cela peut être négligeable s’il s’agit d’un détail insignifiant, mais prétendre qu’il y a une cataracte ou un cancer en est une autre. Comme dans de nombreux cas d’utilisation de LLM, les systèmes manquent aussi de nuances, ce qui crée davantage d’opportunités d’inexactitude.

Alerte Cybersécurité : Le Malware TamperedChef se Propage via de Faux Installateurs

Une nouvelle campagne de cyberattaque mondiale a été détectée, utilisant un malware sophistiqué nommé TamperedChef (ou BaoLoader) qui se propage