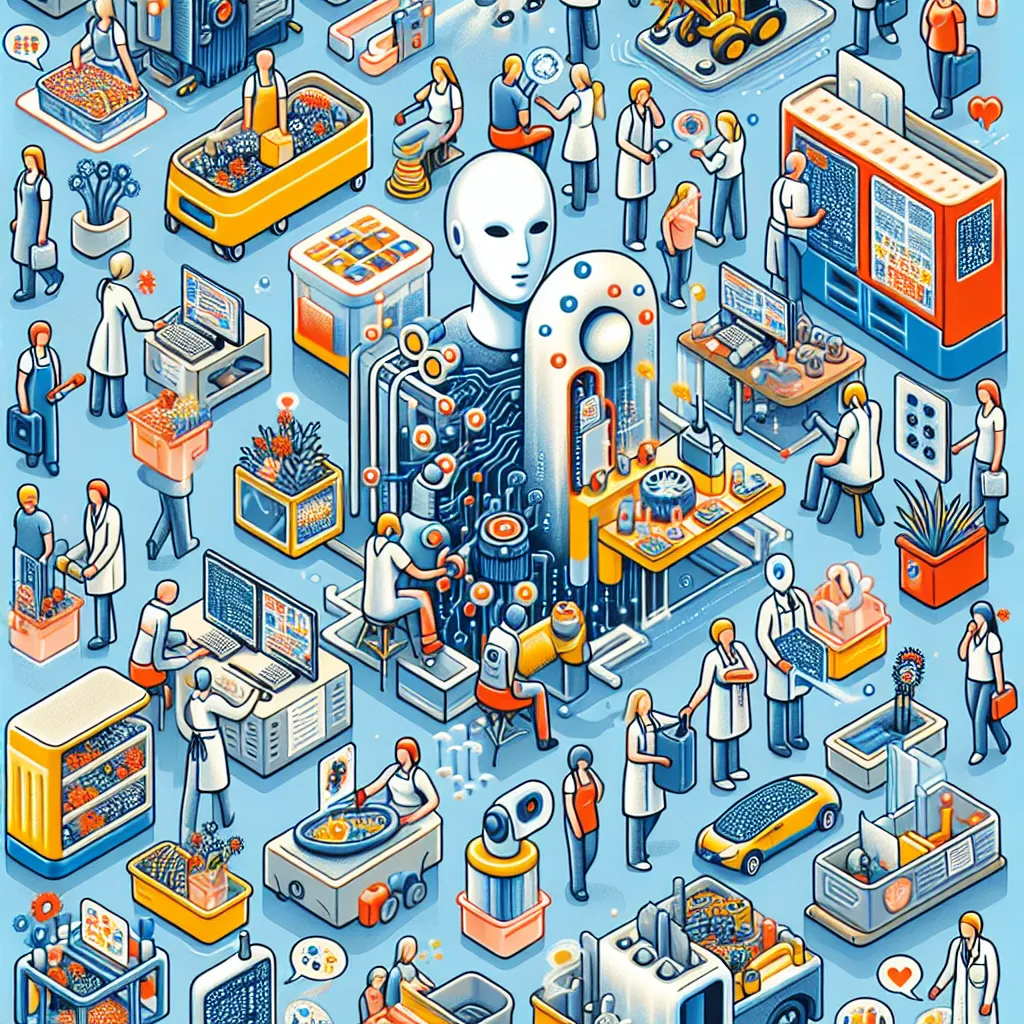

ChatGPT et ses grands concurrents de modèles de langage (LLM) qui produisent du texte à la demande sont très cool. Il en va de même pour les autres fruits de la révolution de l’IA générative : les générateurs d’art, de musique, de sous-titres automatiques et de traduction améliorés. Ils peuvent faire beaucoup de choses (y compris prétendre qu’ils sont conscients, sans que nous devrions les croire), mais il y a un aspect important dans lequel les modèles d’IA diffèrent des personnes : ce sont des processus qui ne s’exécutent que lorsqu’un humain les déclenche et ce uniquement pour accomplir un résultat spécifique. Et puis ils s’arrêtent. Maintenant, imaginez que vous preniez l’un de ces programmes – un bon chatbot, disons, mais quand même juste un chatbot – et que vous lui donniez la capacité d’écrire des notes pour lui-même, de stocker une liste de tâches à faire et l’état des éléments de la liste de tâches, et de déléguer des tâches à d’autres copies de lui-même ou à d’autres personnes. Et au lieu de ne fonctionner que lorsque l’humain l’a incité, vous le faisiez travailler de manière continue sur ces tâches – exactement comme un assistant humain réel. À ce moment-là, sans aucun nouveau saut technologique quelconque – juste quelques outils de base greffés sur un modèle de langage standard – vous auriez ce qu’on appelle un « agent IA », ou une IA qui agit avec une autonomie indépendante pour poursuivre ses objectifs dans le monde. Les agents IA ont été appelés le « futur de l’intelligence artificielle » qui « réinventera la façon dont nous vivons et travaillons », la « prochaine frontière de l’IA ». OpenAI travaillerait apparemment au développement de tels agents, tout comme de nombreuses startups bien financées.

Alerte Cybersécurité : Le Malware TamperedChef se Propage via de Faux Installateurs

Une nouvelle campagne de cyberattaque mondiale a été détectée, utilisant un malware sophistiqué nommé TamperedChef (ou BaoLoader) qui se propage