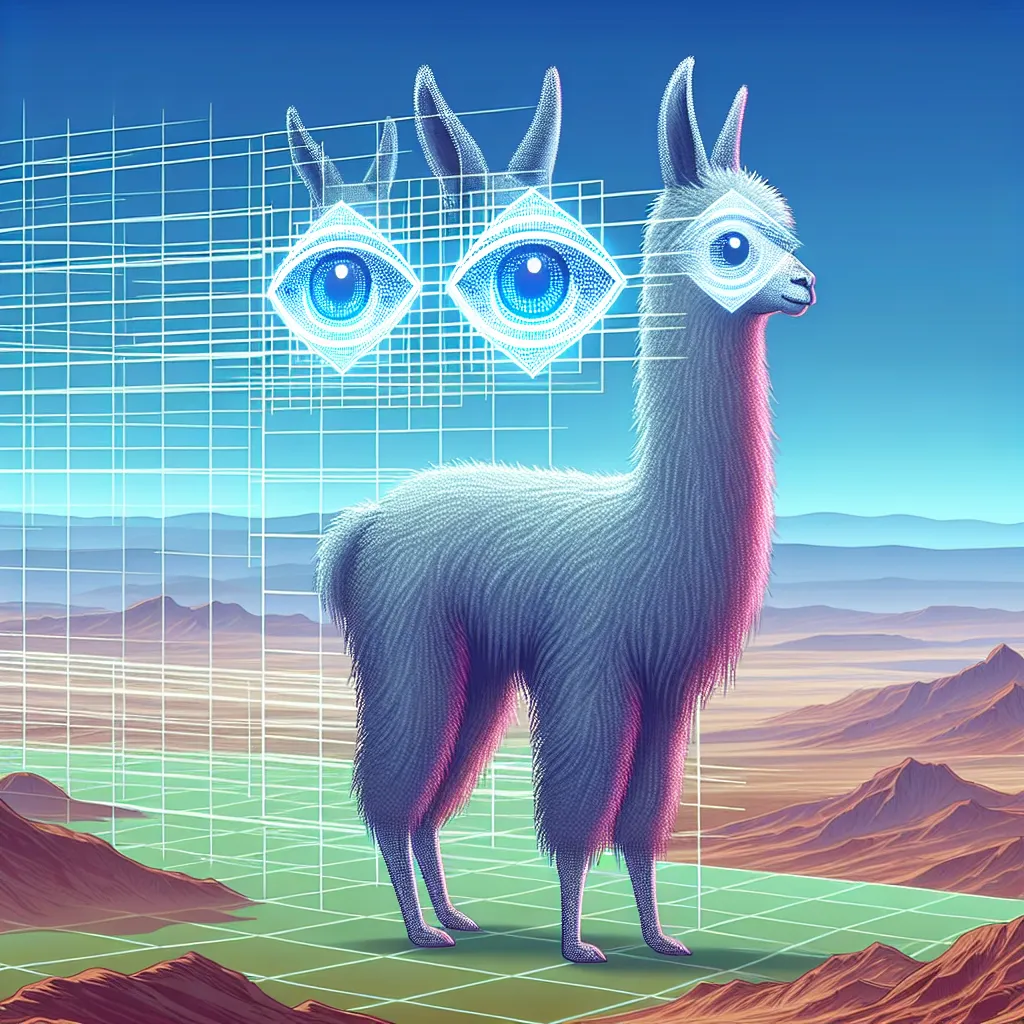

‘Meta a prouvé son expertise dans le développement de modèles de langage ouvert avec la création de la famille Llama. Jusqu’à récemment, ces modèles reposaient uniquement sur des données textuelles, cependant, Meta a maintenant dévoilé des modèles multimodaux qui ont la capacité de comprendre et d’interpréter à la fois les images et le texte simultanément.

Fin le mois dernier, Meta a présenté ces modèles innovants dans le cadre du projet Llama 3. La société affirme que ces modèles multimodaux peuvent travailler efficacement sur l’amalgame de texte et de stimuli visuels pour une compréhension globale du contenu. Ces modèles peuvent être utilisés pour générer des mots-clés pertinents pour une image, un graphique ou un graphique, voire déduire des informations significatives d’une présentation de diapositives.

Le modèle multimodal de Meta est distinct et largement accessible, capable de fonctionner à la fois localement et sur des plateformes cloud. Il peut non seulement identifier le contenu dans une image, mais aussi répondre à des questions ou effectuer des tâches en fonction des informations contenues. Cependant, après avoir évalué ses performances, nous avons déterminé qu’il bénéficierait grandement d’un système cognitif plus sophistiqué pour atteindre son plein potentiel.

Tout comme l’épouvantail dans le Magicien d’Oz qui aspire à un cerveau, ce modèle pourrait également utiliser une capacité de raisonnement plus robuste pour améliorer sa fonctionnalité et son efficacité dans la compréhension et l’interprétation des matériaux composites avec lesquels il est chargé. Malgré cela, l’effort de Meta pour incorporer la compréhension visuelle avec les modèles de langage est une étape notable vers une plateforme IA plus intégrative et complète.’