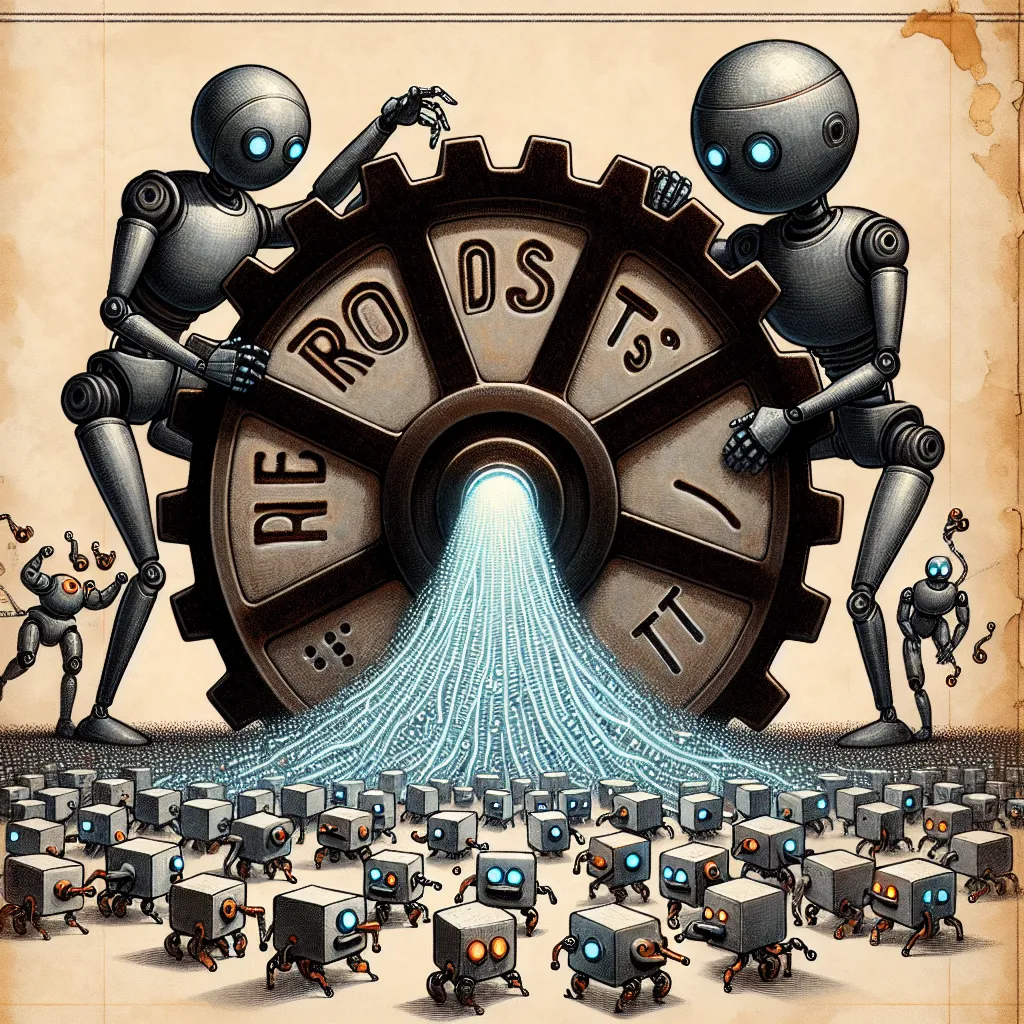

Pour de nombreux utilisateurs, Reddit est devenu le principal référentiel de connaissances communautaires et collaboratives, un fait qui en a certainement fait une cible principale pour les startups d’IA désespérées de données d’entraînement. Cette semaine, Reddit a annoncé qu’elle mettrait en place des mesures pour empêcher le scrap non autorisé par de telles organisations. Ces efforts comprendront une mise à jour du fichier robots.txt, un fichier présent sur la plupart des sites web qui fournit des directives aux robots d’indexation sur ce qu’ils peuvent et ne peuvent pas indexer, « dans les prochaines semaines ». Si vous êtes curieux, vous pouvez trouver le robots.txt actuel de Reddit ici. Il convient de noter que le robots.txt ne peut pas contraindre les scrapers à faire quoi que ce soit; le contenu du fichier est davantage des directives ou des demandes fermes. Les robots d’exploration peuvent être amenés à les ignorer, donc Reddit dit qu’il continuera de limiter les taux et/ou de bloquer les bots malveillants – vraisemblablement ceux qui ignorent robots.txt – pour accéder au site. En effet, les crawlers qui rejettent robots.txt risquent d’être bloqués totalement, si possible, sur les sites en général par leurs administrateurs. Ces mesures, aussi vagues soient-elles actuellement, semblent être spécifiquement ciblées sur ceux qui accèdent à Reddit dans un but lucratif. Le site dit que les « acteurs de bonne foi – comme les chercheurs et les organisations telles que l’Internet Archive – continueront à avoir accès au contenu de Reddit à des fins non commerciales ».

Alerte Cybersécurité : Le Malware TamperedChef se Propage via de Faux Installateurs

Une nouvelle campagne de cyberattaque mondiale a été détectée, utilisant un malware sophistiqué nommé TamperedChef (ou BaoLoader) qui se propage