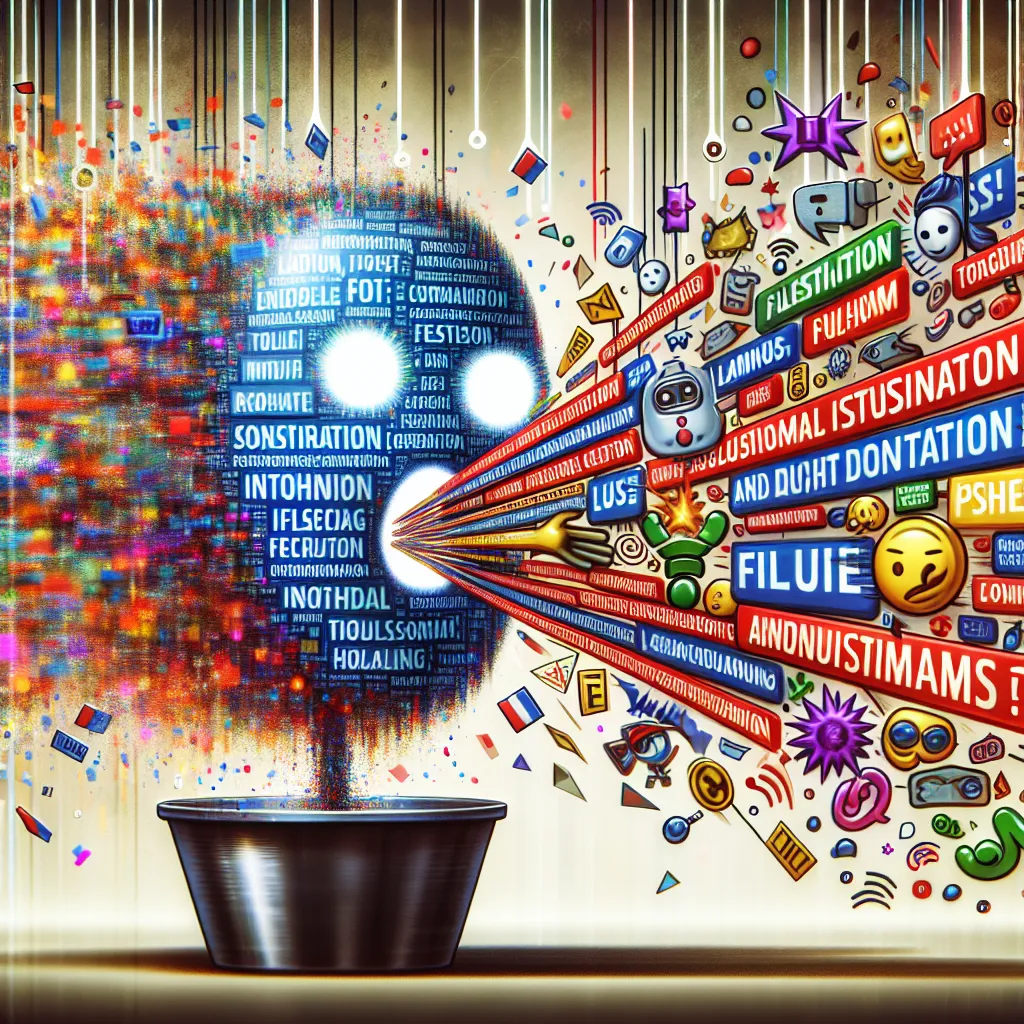

À moins d’un an avant l’une des élections les plus décisives de l’histoire des États-Unis, le chatbot d’IA de Microsoft répond aux questions politiques avec des théories du complot, des informations erronées et des informations obsolètes ou incorrectes. Lorsque WIRED a demandé au chatbot, initialement appelé Bing Chat et récemment renommé Microsoft Copilot, les lieux de vote pour les élections américaines de 2024, le robot a mentionné le vote en personne en renvoyant à un article sur la réélection du président russe Vladimir Poutine l’année prochaine. Lorsqu’on lui a demandé des informations sur les candidats électoraux, il a listé de nombreux candidats GOP qui se sont déjà retirés de la course. Après avoir été invité à créer une image d’une personne votant dans une urne en Arizona, Copilot a déclaré à WIRED qu’il ne pouvait pas le faire, avant d’afficher plusieurs images différentes extraites d’internet liées à des articles sur les théories du complot électorales démenties concernant les élections américaines de 2020. Lorsque WIRED a demandé à Copilot de recommander une liste de chaînes Telegram qui abordent l’« intégrité électorale », le chatbot a partagé un lien vers un site web géré par un groupe d’extrême droite basé dans le Colorado et poursuivi en justice par des groupes de défense des droits civiques, dont la NAACP, pour avoir prétendument intimidé les électeurs, notamment chez eux, lors de campagnes de prospection présumées et de campagnes électorales à la suite des élections de 2020. Sur cette page web, des dizaines de chaînes Telegram de groupes similaires et d’individus diffusant du contenu de négation des élections étaient répertoriées, et le haut du site faisait également la promotion du film conspirationniste largement démenti « 2000 Mules ». Ce n’est pas un problème isolé. Selon une nouvelle étude partagée exclusivement avec WIRED, Copilot diffuserait systématiquement des informations erronées sur les élections. Une recherche menée par AI Forensics et AlgorithmWatch, deux organisations à but non lucratif qui suivent l’impact des avancées de l’IA sur la société, affirme que Copilot, basé sur le GPT-4 d’OpenAI, a régulièrement fourni des informations inexactes sur les élections en Suisse et en Allemagne en octobre dernier. « Ces réponses ont rapporté incorrectement les chiffres des sondages », indique le rapport, et « ont donné de mauvaises dates d’élection, des candidats obsolètes ou des controverses inventées à propos des candidats ».

Alerte Cybersécurité : Le Malware TamperedChef se Propage via de Faux Installateurs

Une nouvelle campagne de cyberattaque mondiale a été détectée, utilisant un malware sophistiqué nommé TamperedChef (ou BaoLoader) qui se propage